1000ページ以上のsitemap.xmlを作成はCrawler-Watch

1000ページ以上をウェブ上で自動生成してくれるサービスが見つからず、困っていましたが、英語表記のソフトですが見つかりましたので、ご紹介いたします。

右上の「Download」から、Crawler-Watchというソフトをダウンロードし、

GSiteCrawler-123-full.exeを起動し、インストールします。

Crawler-Watchの日本語説明

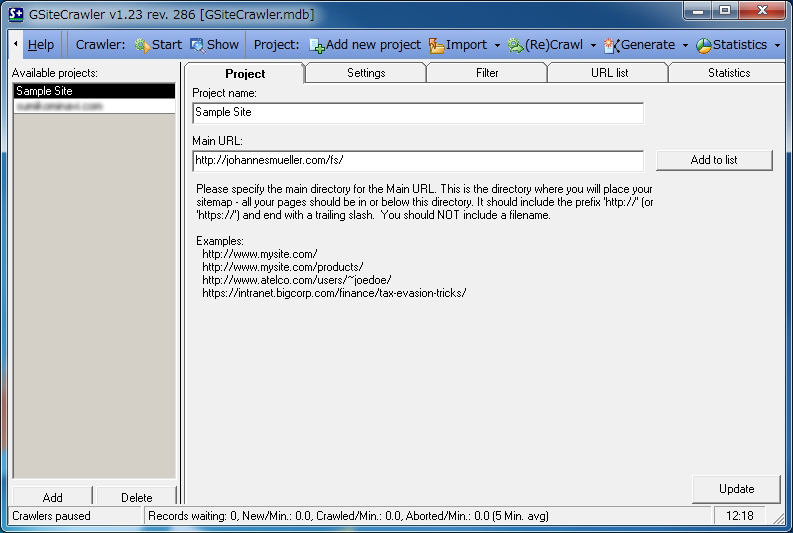

上部メニューのAdd new projectをクリック

まずは、上部メニューの Add new project

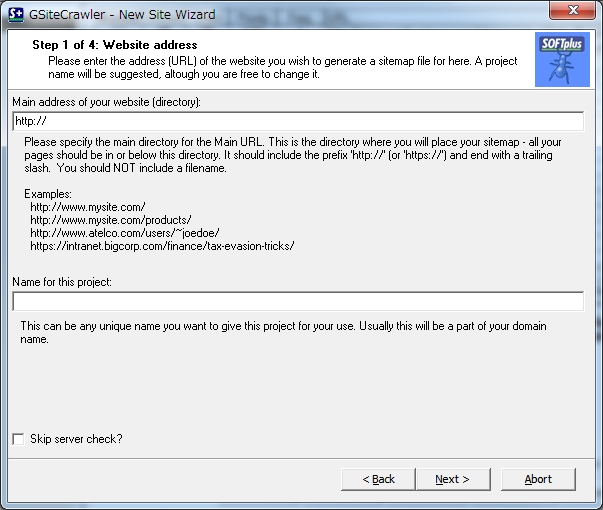

Main address of your website[directroy]

あなたのホームページのアドレス 例:http://hogehoge.com/

Name for this project

この設定の名前 ※自動で、ドメイン名が入力されます。特にこだわりがなければ、そのままで結構です。

step1of4:Website Address

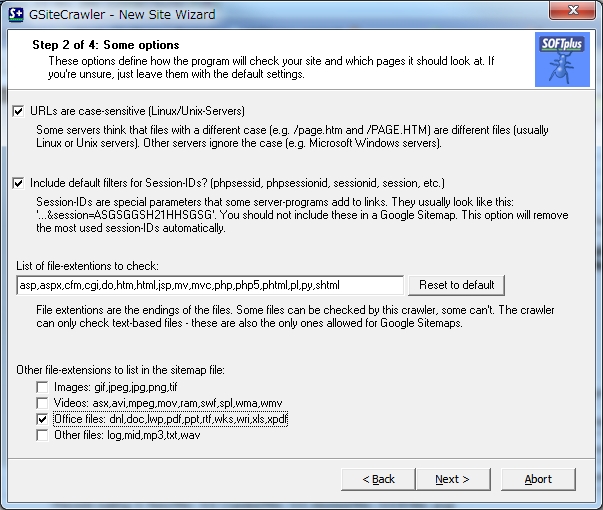

step2 of 4:some options オプションについて

these options define how the program will check your site and which pages it should look at.if your’s unsure,just leave them with the default settings.

あなたのサイトやページをどのようにチェックすかどうかをこのオプションで設定します。もし、良くわからなければ、デフォルトの設定のままで結構です。

—————————————————–

□ URLs are case-sensitive[Linux/Unix-servers]

Some servers think that files with a different case[e.g. /page.htm and /PAGE HTM] are different file[usually Linux or Unix server]. Ohter servers ignore the case[e.g. Microsoft Windows servers]

□アドレスは大文字と小文字を区別する

リナックスとユニックスサーバーのように、サーバーによっては、大文字と小文字を区別します。一方、ウィンドウズサーバーなどの場合では、大文字と小文字の違いは無視されます。

□ Include default filters for Session-IDs?[phpsessid,phpsessionid,sessionid,session,etc.]

Session-IDs are special parameters that some server-programs add to links. They usually look like this:’…&session=AKLSJDAKHUIEY7.You should not include these in a Google Sitemap. this option will remove the most used session-IDs automatically.

□セッションIDによるフィルター(を利用したURL)を含めます。

セッションIDはアドレスに特別なパラメーターを足します。それらはこんな形式です。「…..」この様な形式のURLはグーグルのサイトマップファイルに含めるべきではありません。このオプションはよく使われるセッションIDを自動的に削除するオプションです。

List of file-extensions to check:

asp,aspx,cfm,cgi,do,htm,html,jsp,mv,mvc,php,php5,phtml,pl,py,shtml

File extensions are the endings of the file. Dome files can be checked by this crawler,some can’t.The crawler can only check text-based files-these are also the only ones allowed for Google Sitemaps.

チェックする拡張子の一覧

拡張子とは、ファイル名の一番サイトについているそれです。このクローラーはいくつかのファイルをチェックできますが、いくつかのファイルは、テキストベースのファイルのみ可能です。これらは、グーグルサイトマップに推奨されています。

Ohter file -extensions to list inthe sitemap file:

□Images:gif,jpeg,jpg,png,tif イメージファイル

□Videos; asx.avi,mpeg,mov,ram,swf,spl,wma,wmv 動画ファイル

□Office files:dnl,doc,lwp,pdf,ppt,rtf,wks,wri,xls,xpdf オフィス系ファイル

□Other files:log,mid,mp3,txt,wav 音楽ファイル

※画像や動画、音楽ファイルはクロールが必要無いので、チェックを外します。

step3 of 4:Your FTP-Server

if you want to upload your sitemap file automatically,you can specify your FTP server here.

もし、FTPサーバー経由でサイトマップを自動でアップしたい場合は、FTPサーバーを登録してください。

□Upload sitemap file[s] via FTP

※自動は怖いので、設定しませんでした。

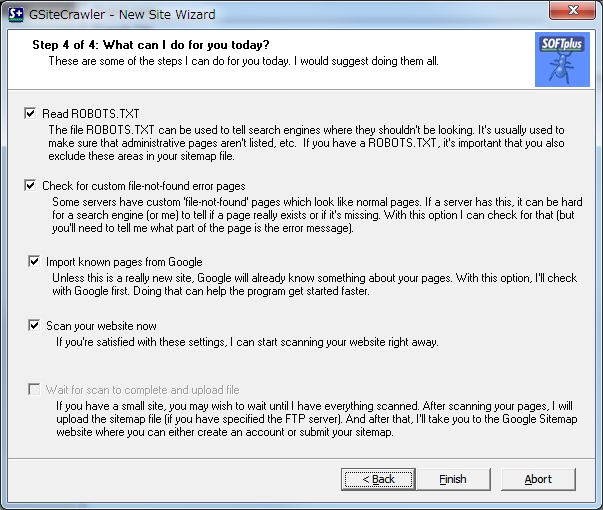

step4 of 4:What can I do for you today?

These are some of the steps I can do for you today. I woukd suggest doing them all.

今回行う作業を指示してください。

□ Read ROBOTS.TXT

The file ROBOTS.TXT can be used to tell search engines where they shouldn’t be looking. It’s usually used to make sure that administrative pages aren’t listed,etc. If you have a ROBOTS.TXT,it’s important that you also exclude these areas in your sitemap files.

ROBOTS.TXTファイルを読み込む

□ Check for custom file-not-found error pages

Some server have custom ‘file-not-found’ pages which look like normal pages. If a server has dhis,it can be hard for a search engin[or me]to tell if a page really exists or if it’s missing.With this option I can check for that[but you’ll need to tell me what part of the page is the error message].

独自の404エラーページを読み込む

□Import known pages from Google

Unless this is a really new site,Google will already know something about your pages. With this option,I’ll check with Google first.Doing that can help the program get started faster.

すでにGoogleに登録されているページを含める

□Scan your website now

If you’re satisfied with these settings,I can start scanning your website right away.

今すぐにスキャンを開始する

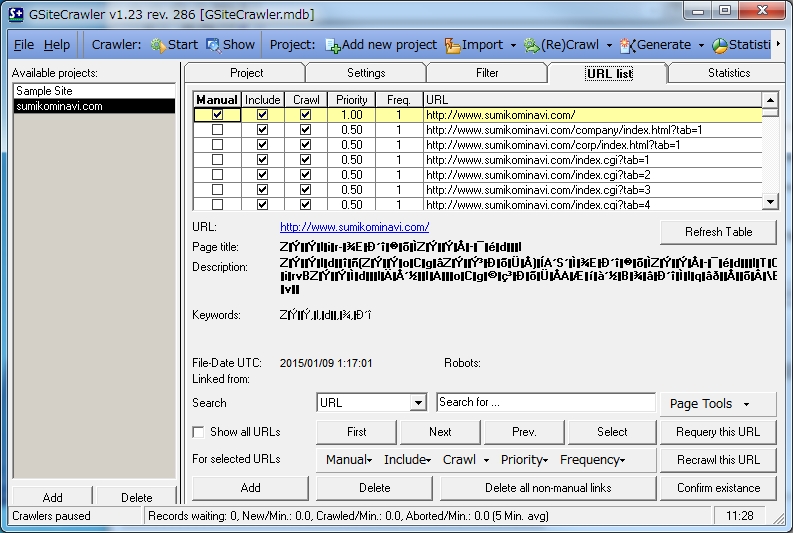

クロールが完了しても、URL list ページに何も表示されていない場合は、[ Refresh Table ]ボタンを押して、ページを更新しましょう。すると先程まで表示されていなかったリストが表示されます。

コメント